強化學習的思想源于行為心理學(behavioural psychology)的研究。1911年Thorndike提出了效用法則(Law of Effect):一定情境下讓動物感到舒服的行為�,就會與此情景加強聯系�����,當此情景再現時�,動物的這種行為也更易再現��;相反�,讓動物感覺不舒服的行為,會減弱與此情景的聯系,此情景再現時,此行為將很難再現��。換句話說�����,那種行為會被記住取決于該行為產生的效用����。例如:在主人扔出飛盤時����,狗叼回飛盤給主人的行為獲得了肉骨頭,將會使得“狗叼回扔出的飛盤”這個行為和“主人扔出飛盤時”這個情景加強了聯系�,“獲得肉骨頭”的效用將使狗記住“叼回扔出的飛盤”的行為��。

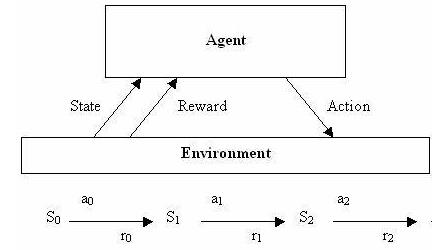

在給定情境下,得到獎勵的行為會被“強化”而受到懲罰的行為會被“弱化”���。這樣一種生物智能模式使得動物可以從不同行為嘗試獲得的獎勵或懲罰學會在該情境下選擇訓練者最期望的行為。這就是強化學習的核心機制:用試錯(trail-and-error)來學會在給定的情境下選擇最恰當的行為��。Sutton定義強化學習為:通過試錯學習如何最佳地匹配狀態(states)和動作(actions)����,以期獲得最大的回報(rewards)��。

強化學習不僅直接模仿了生物學習的智能模式��,而且也不像其它大多數機器學習方法中,智能體需要被告訴去選擇哪種動作��,使用強化學習方法的智能體能夠通過嘗試不同的動作�����,自主地發現并選擇產生最大回報的動作���。正如Tesauro所描述的那樣:強化學習使得智能體可以根據自己的經驗進行自主地學習�����,既不需要任何預備知識也不依賴任何外部智能“老師”的幫助。

強化學習大腦

“如何最佳的匹配狀態和動作”���,強化學習所解決的這樣很具有普遍性的問題。使得強化學習在機器人學����,最優控制���,棋類對弈�,策略博弈��,飛行控制����,導彈制導����,預測決策,金融投資以及城市交通控制等領域都有大量的應用。

再從計算機實現的角度看,大多數其它機器學習的方法都需要實現智能體的人事先知道要智能體解決的問題是“什么”,以及問題“怎么樣”來解決����。再通過編寫指令來告訴智能體如何求解����。遺憾的是�����,知道“做什么”遠比知道“怎么做”的情形多得多����。例如�,對于這樣一個問題:一個城市交通網絡由多個十字路口以及它們之間的道路組成,每一個十字路口的交通燈由一個Agent控制����,那么這多個Agent應該如何協作控制紅綠燈的時段長短�,使得進入該城市交通網絡的所有車輛在最短時間內離開該城市交通網絡呢�?Agent學習要“做什么”的問題是清晰的:使所有車輛以最短時離開該城市交通網絡;但“怎樣做”卻是復雜和困難的����。

強化學習提供了這樣一種美好的前景:只要確定了回報���,不必需要規定Agent怎樣完成任務�����,Agent 將能夠通過試錯學會最佳的控制策略�。在前面的多Agent交通控制問題中,只需規定所有車輛通過時間越短獲取的回報越大�����,那么這多個Agent將自主學會最優的交通燈協作控制策略使得所有車輛在最短時間內通過該城市網絡�����。盡管直到今天��,解決這樣多個十字路口的交通燈控制問題,強化學習依然面臨巨大的計算量和較長的計算時間。但從實現的角度來看,本文認為強化學習是一種可以把人從必須考慮“怎么做”中解放出來的機器學習方法,也相信強化學習是能夠使得智能能夠從如Bezdek描述的從計算智能進化到人工智能直至生物智能的途徑之一�����。

強化學習示意

強化學習的研究歷史:1954年Minsky首次提出“強化”和“強化學習”的概念和術語��。1965年在控制理論中Waltz和傅京孫也提出這一概念���,描述通過獎懲的手段進行學習的基本思想���。他們都明確了“試錯”是強化學習的核心機制�。Bellman在1957年提出了求解最優控制問題以及最優控制問題的隨機離散版本馬爾可夫決策過程(Markov Decision Process�����,MDP)的動態規劃(Dynamic Programming)方法�,而該方法的求解采用了類似強化學習試錯迭代求解的機制����。盡管他只是采用了強化學習的思想求解馬爾可夫決策過程,但事實上卻導致了馬爾可夫決策過程成為定義強化學習問題的最普遍形式�,加上其方法的現實操作性����,以致后來的很多研究者都認為強化學習起源于Bellman的動態規劃����,隨后Howard提出了求解馬爾可夫決策過程的策略迭代方法�����。

到此時強化學習的理論基礎(馬爾可夫決策過程)和求解算法:試錯的策略迭代基本確定下來�����。此后一段時間�,強化學習被監督學習(supervised learning)的光芒所遮掩�����,像統計模式識別����,人工神經網絡均屬于監督學習��,這種學習是通過外部有知識的監督者提供的例子來進行學習的����,但這種學習已經完全違背了強化學習的宗旨����,因為監督學習有了“教師”(supervisor),有了預備知識(examples)�����。到1989年��,Watkins提出的Q學習進一步拓展了強化學習的應用和完備了強化學習。Q學習使得在缺乏立即回報函數(仍然需要知道最終回報或者目標狀態)和狀態轉換函數的知識下依然可以求出最優動作策略����,換句話說�,Q學習使得強化學習不再依賴于問題模型�����。此外Watkins還證明了當系統是確定性的馬爾可夫決策過程���,并且回報是有限的情況下�,強化學習是收斂的���,也即一定可以求出最優解��。至今�����,Q學習已經成為最廣泛使用的強化學習方法。

聯系:highspeedlogic

QQ :1224848052

微信:HuangL1121

郵箱:1224848052@qq.com

網站:http://www.mat7lab.com/

網站:http://www.hslogic.com/

微信掃一掃: