CNN 101: 卷積神經(jīng)網(wǎng)絡(luò)的交互式視覺學(xué)習(xí)

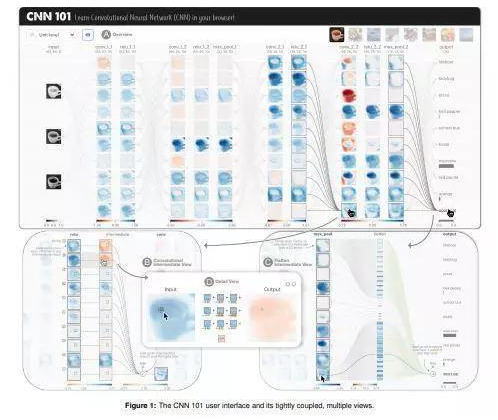

為了應(yīng)對深度學(xué)習(xí)模型中的復(fù)雜性挑戰(zhàn),研究人員開發(fā)了CNN 101,這是一個交互式的可視化系統(tǒng),可以幫助學(xué)生更好地了解和學(xué)習(xí)卷積神經(jīng)網(wǎng)絡(luò),它是基礎(chǔ)的深度學(xué)習(xí)模型體系結(jié)構(gòu)。

使用現(xiàn)代Web技術(shù)構(gòu)建的CNN 101無需專用硬件即可在用戶的Web瀏覽器中本地運行。通過緊密集成的交互式視圖,CNN 101通過解釋單神經(jīng)元級別以及層級別的卷積,激活和池化操作,提供了模型工作方式的概述和詳細說明。

CNN 101進一步擴大了公眾對深度學(xué)習(xí)技術(shù)的教育途徑。它應(yīng)用了交互式可視化技術(shù),為用戶提供了一種更簡單的方法來學(xué)習(xí)深度學(xué)習(xí)機制并建立神經(jīng)網(wǎng)絡(luò)直覺。并且,對于現(xiàn)有的通過交互式可視化來解釋復(fù)雜機器學(xué)習(xí)算法的研究工作,CNN 101可以與他們結(jié)合在一起。

作者還計劃擴展CNN 101的功能,用來進一步支持用戶自定義和個性化的學(xué)習(xí)。他們還致力于將CNN 101部署和開源在類似于TensorFlow Playground和GAN Lab的平臺上,以便來自世界各地的學(xué)習(xí)者都可以輕松訪問。

CNN 101 演示視頻:

https://www.youtube.com/watch?v=g082-zitM7s&feature=youtu.be

原文:

https://arxiv.org/abs/2001.02004v1

主動人體姿勢估計的深度強化學(xué)習(xí)

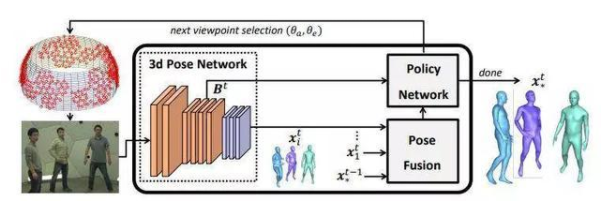

姿勢深度強化學(xué)習(xí)(Pose-DRL)是一種在密集攝影機中運行的,基于完全可訓(xùn)練的深度強化學(xué)習(xí)(DRL)的主動式姿勢估計架構(gòu),該架構(gòu)可以選擇適當?shù)囊朁c以提供基礎(chǔ)的單眼姿勢預(yù)測器。

研究人員使用單目標估計器和多目標估計器對模型進行評估,在兩種情況下均獲得了良好的結(jié)果。該系統(tǒng)還學(xué)習(xí)了時間自動停止的情形,以及向視頻中的下一時間處理步驟過渡的功能。

研究人員稱:“在使用Panoptic多視圖設(shè)置進行的廣泛實驗中,對于包含多個人的復(fù)雜場景,我們證明了該模型學(xué)會了選擇與強多視圖基線相比明顯更準確的姿勢估計的視點。”

該系統(tǒng)學(xué)習(xí)選擇視圖集,與強多視圖基線相比,產(chǎn)生的姿態(tài)估計更準確。結(jié)果不僅顯示了智能視點選擇的優(yōu)勢,而且還證明了“少即是多”,融合太多可能不正確的視點估計反而會導(dǎo)致結(jié)果變差。

閱讀更多:

https://arxiv.org/abs/2001.02024v1

多語言神經(jīng)機器翻譯的綜合研究

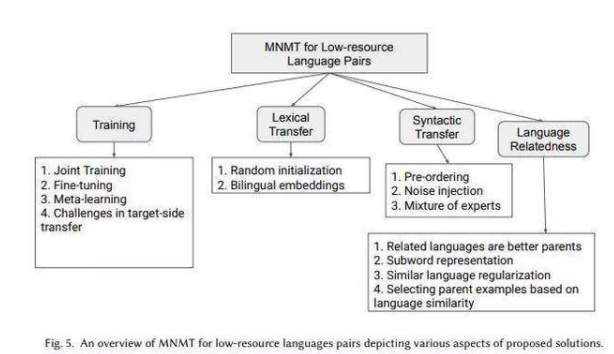

在本文中,日本大阪大學(xué)和日本國立信息與通信技術(shù)研究所,以及印度的微軟人工智能研究院的研究人員對現(xiàn)有的多語言神經(jīng)機器翻譯(MNMT)文獻進行了深入調(diào)查,以期使研究人員和從業(yè)人員對MNMT前景有更深入的了解。

他們根據(jù)中心使用實例對MNMT中的各種技術(shù)進行了簡單分類,并根據(jù)資源場景,基礎(chǔ)建模原理,核心問題和挑戰(zhàn)對它們進行 進一步分類。他們還盡可能地通過相互比較來解決幾種技術(shù)的優(yōu)缺點,并討論MNMT的未來發(fā)展方向。

MNMT在過去幾年中已經(jīng)起步。盡管它帶來了許多令人振奮的進步,但仍有許多有趣的方向可供進一步探索。

首先,這項工作涵蓋了與多語言NMT的主要場景相關(guān)的文獻,包括多路,低資源或零資源(轉(zhuǎn)移學(xué)習(xí),數(shù)據(jù)透視和零鏡頭方法)和多源翻譯。本文系統(tǒng)地匯編了主要的設(shè)計方法及其變體,主要的MNMT問題及其建議的解決方案。

對于NMT的初學(xué)者和專家而言,這是朝著促進和加速MNMT研究邁出的重要一步。任何對于MNMT感興趣的人,都可以以此作為起點和新思想的來源。

原文:

https://arxiv.org/abs/2001.01115v2

強大且可擴展的快速分類器將用于車輛跟蹤和車輛再識別

近期的一項研究提出了一個針對不同條件下攝像機網(wǎng)絡(luò)中視頻分析的協(xié)作分類器框架,這些條件包括多尺度、多分辨率攝像機以不同的遮擋、模糊和方向捕獲環(huán)境。提出這一框架的研究人員來自于美國佐治亞理工學(xué)院和巴西圣保羅大學(xué),他們描述了一種用于車輛跟蹤和車輛再識別的實現(xiàn)方式,他們在其中實施了零彈學(xué)習(xí)(ZSL)系統(tǒng)來對車輛執(zhí)行自動化跟蹤。

對VeRi-776和Cars196的評估表明:成組的分類器框架具有強大的對抗能力,可以擴展到不斷變化的視頻特征(例如新的車輛類型 / 品牌和新的攝像頭)。并且,他們與當前的離線視頻分析方法相比更具有實時性能。

這項研究提出了一種用于車輛跟蹤的全新技術(shù),它同時也能進行端到端的車輛屬性提取和車輛識別。它簡單而強大的基礎(chǔ)模型與當前的最新技術(shù)相比具有一定競爭優(yōu)勢,而且其參數(shù)要少幾個數(shù)量級。研究人員在基本模型中使用大約1200萬個參數(shù)來實現(xiàn)64.4 mAP,而在MTML-OSG中使用100多個參數(shù)時則具有62.6的平均平均精度(mAP,一種用于評估排名和檢索的指標)

減少參數(shù)數(shù)量將其與當前方法的性能進行對比,研究人員們可以認定:這一框架能夠達到這一領(lǐng)域內(nèi)業(yè)界最頂尖的水準,這也是這一方法的優(yōu)勢之一。

原文:

https://arxiv.org/abs/1912.04423v2

Sparse-GAN在視網(wǎng)膜OCT圖像疾病檢測中的應(yīng)用

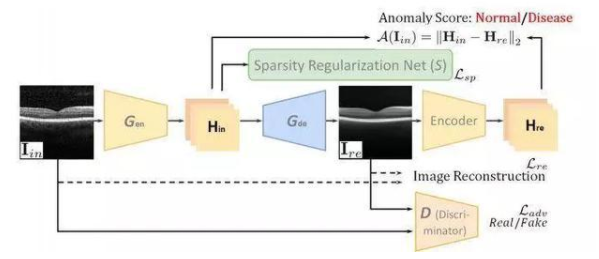

CNN等技術(shù)使得我們可以用計算機視覺技術(shù)和深度學(xué)習(xí)方法來檢測視網(wǎng)膜OCT圖像中的病變。 但是,這樣的方法需要大量的數(shù)據(jù)來進行訓(xùn)練,深度學(xué)習(xí)應(yīng)用也正是因此被限制在了醫(yī)學(xué)圖像分析中。而如果我們究其原因就會發(fā)現(xiàn):從具有一種或幾種疾病的數(shù)據(jù)集中訓(xùn)練出來的深度學(xué)習(xí)系統(tǒng)無法檢測到其他訓(xùn)練集中沒有出現(xiàn)過的疾病。

為了解決這一問題,在Image-to-Image GAN(注:GAN指的是“對抗神經(jīng)網(wǎng)絡(luò)”)的啟發(fā)下,研究人員現(xiàn)在建議在這項工作中采用Image-to-Image GAN進行醫(yī)學(xué)圖像的異常檢測,并建議將重建圖像映射到潛伏空間,并附加編碼器以減少圖像噪聲的影響。

與此同時,研究人員們還建議規(guī)范化潛在特征的稀疏性,以僅使用正常訓(xùn)練數(shù)據(jù)來呈現(xiàn)所謂的稀疏約束生成對抗網(wǎng)絡(luò)(Sparse-GAN),以此進行圖像異常檢測。

在OCT成像中,來自健康受試者的3D掃描可提供數(shù)百個“B掃描”圖像而無損傷。如果我們將病變視為來自健康受試者的異常圖像,可以使用沒有病變的OCT “B掃描”來訓(xùn)練異常檢測系統(tǒng)。

Sparse-GAN能夠預(yù)測空間中潛在的異常,而不是圖像級別的異常,并且還受到新穎的Sparsity Regularization Net的約束。而在可公開獲得的數(shù)據(jù)集上對其進行的評估表明,它的性能優(yōu)于業(yè)界最新方法。

也就是說,Sparse-GAN可用于疾病篩查,其中訓(xùn)練集中只有健康數(shù)據(jù)即可。這樣,可以減輕數(shù)據(jù)收集和注釋的難度。該方法還可以預(yù)測異常激活圖,以顯示病變以進行臨床診斷。

原文:

https://arxiv.org/abs/1911.12527v2

其他爆款論文

第一個能夠通過單一視角重現(xiàn)房間3D布局的方法:

https://arxiv.org/abs/2001.02149v1

PaRoT:一個基于TensorFlow的全新系統(tǒng):

https://arxiv.org/abs/2001.02152v1

全新的、現(xiàn)實的、具有關(guān)注意識的眾包方案:

https://arxiv.org/abs/1912.11238v2

第一個能夠幫助我們更好地理解深度學(xué)習(xí)的理論系統(tǒng):

https://arxiv.org/abs/2001.00939v2

一種在計算機安全性領(lǐng)域中比較和評估不同解釋方法的標準:

https://arxiv.org/abs/1906.02108v3

數(shù)據(jù)集

數(shù)據(jù)集是怎么來的:

https://arxiv.org/abs/1803.09010v5

使用VizWiz數(shù)據(jù)集瀏覽器搜索和瀏覽一組大型機器學(xué)習(xí)數(shù)據(jù)集:

https://arxiv.org/abs/1912.09336v1

AI大事件

AI是如何幫助我們在中國戰(zhàn)勝貧困的:

https://time.com/5759428/ai-poverty-china/

新算法幫你找到最佳讀物:

http://news.mit.edu/2019/finding-good-read-among-billions-of-choices-1220

利用AI改善與消費者的聯(lián)系:

https://www.forbes.com/sites/forbesagencycouncil/2020/01/08/leveraging-ai-to-enhance-connection-with-consumers-12-techniques-for-marketers/#5fbdbd70cb69

對于美國公司來說,在美國建立實驗室會越來越難:

https://www.wired.com/story/export-controls-threaten-ai-outposts-china/?utm_brand=wired&utm_social-type=earned

MIT開發(fā)面向中學(xué)生的AI新課,傳授AI倫理和基礎(chǔ)知識:

http://news.mit.edu/2019/bringing-artificial-intelligence-and-mit-middle-school-classrooms-1230